Przez lata generatywne wideo AI wyglądało jak zombie – poruszało ustami, ale oczy miało martwe. Tavus postanowiło to zmienić i właśnie wypuściło Phoenix-4, model renderowania wideo w czasie rzeczywistym, który twierdzi, że pokonał problem „doliny niesamowitości”.

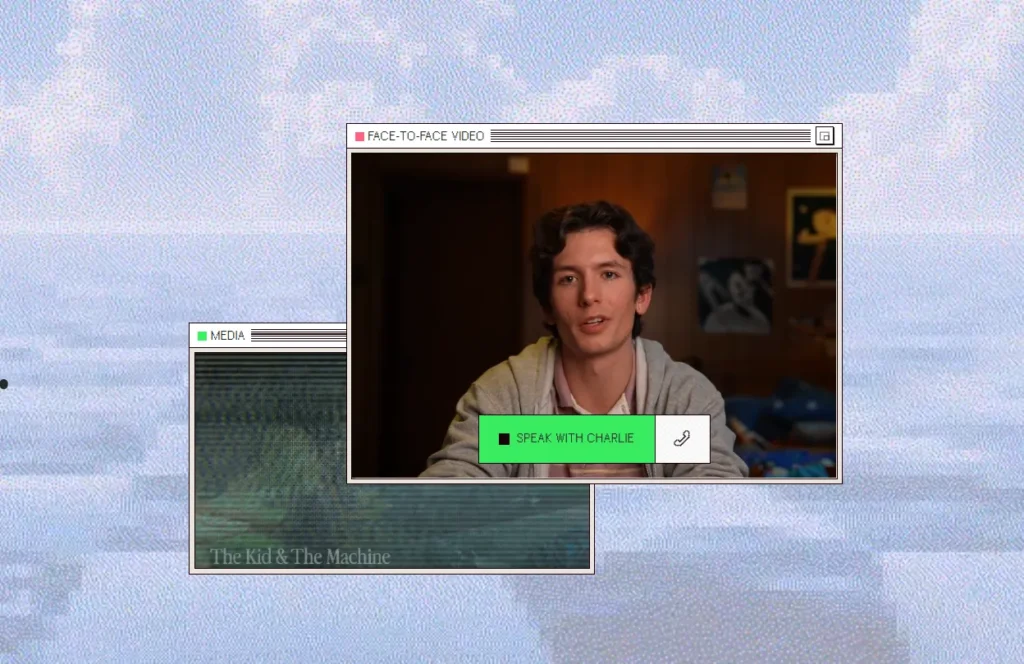

Jeśli nigdy nie słyszeliście o Tavus – to startup budujący infrastrukturę do tak zwanych Conversational Video Interfaces (CVI). Prosto mówiąc: cyfrowe awatary, które rozmawiają z użytkownikami jak prawdziwi ludzie. Klienci obsługi klienta, wirtualni asystenci medyczni, syntetyczni lektorzy. Rynek jest ogromny, a problem był zawsze ten sam – technologia wyglądała sztucznie.

Trzy modele zamiast jednego

Phoenix-4 to nie jest pojedynczy model. To trio komponentów, które działają razem i każdy robi coś innego:

- Raven-1 – „zmysły” systemu. Analizuje mimikę twarzy użytkownika i ton głosu, żeby rozumieć kontekst emocjonalny rozmowy w czasie rzeczywistym.

- Sparrow-1 – zarządza rytmem konwersacji. Decyduje kiedy awatar powinien przerywać, czekać, kiedy zamilknąć. To brzmi trywialnie, ale złe wyczucie momentu natychmiast niszczy iluzję.

- Phoenix-4 – silnik renderowania. Generuje obraz.

To podejście przypomina mi bardziej architekturę systemu niż typowy „nowy model AI”. Ktoś tu naprawdę pomyślał o tym, jak człowiek faktycznie prowadzi rozmowę.

Koniec z GAN-ami, witaj Gaussian-diffusion

„To co mnie uderza w Phoenix-4 to nie sama jakość obrazu, tylko decyzja architektoniczna. Odejście od GAN-ów na rzecz Gaussian-diffusion w renderowaniu twarzy to nie jest oczywisty ruch. Przez lata GANy dominowały w syntezie twarzy i miały swoje zalety – szybkość, przewidywalność. Tavus zakłada, że diffusion daje im lepszą kontrolę nad mikrowyrażeniami i spójnością przestrzenną. Zobaczymy czy to zadziała w praktyce na skalę komercyjną.” – Piotr Wolniewicz, Redaktor Naczelny AIPORT.pl

Właśnie ta zmiana ma rozwiązywać problem „uncanny valley”. Gdy tradycyjne modele oparte na GAN-ach generowały twarz obracającą głowę, tekstury traciły spójność – skóra wyglądała jak maska nałożona na ruchomy obiekt 3D. Gaussian-diffusion pozwala modelowi lepiej symulować to, jak światło naprawdę zachowuje się na skórze, jak mięśnie policzków reagują na uśmiech, jak napięcie skóry zmienia się przy mikroekspresji wokół oczu.

Model streamuje 30 klatek na sekundę przez WebRTC – ten sam protokół, który napędza Google Meet czy Zoom.

600 milisekund robi całą różnicę

Latencja poniżej 600ms end-to-end. To kluczowa liczba.

W rozmowie wideo opóźnienie powyżej sekundy jest odczuwalne i psuje naturalność interakcji. Phoenix-4 osiąga to dzięki architekturze „stream-first” – zamiast generować pełny plik wideo i dopiero go odtwarzać, model renderuje i wysyła pakiety wideo przyrostowo. Pierwsze klatki docierają do przeglądarki użytkownika w ułamku sekundy.

API do sterowania emocjami

Deweloperzy dostają do ręki Emotion Control API. Można dosłownie wstrzyknąć stan emocjonalny do awatara przez parametr w zapytaniu do API. Aktualnie obsługiwane stany to:

- radość (joy)

- smutek (sadness)

- złość (anger)

- zaskoczenie (surprise)

Gdy ustawisz emotion: joy, model nie podnosi po prostu kącików ust. Koryguje całą geometrię twarzy – policzki, zmarszczki wokół oczu, napięcie mięśni. To warunkowe generowanie wideo, gdzie emocja działa jak wektor sterujący syntezą obrazu równolegle z fonemami z text-to-speech.

Dwie minuty i masz swojego cyfrowego bliźniaka

Żeby stworzyć własną „Replikę” – cyfrowego bliźniaka konkretnej osoby – wystarczą 2 minuty materiału wideo. Tavus trenuje na tym unikalny replica_id, który potem wdrażasz przez SDK i endpoint POST /conversations.

To otwiera oczywiste pytania etyczne, których Tavus na razie głośno nie adresuje. Dwie minuty to naprawdę mało. Prawie każdy z nas ma tyle nagrań w internecie.

Phoenix-4 jest dostępny teraz. Demo można sprawdzić pod adresem phoenix.tavuslabs.org, a dokumentacja techniczna żyje w oficjalnych docs Tavus.