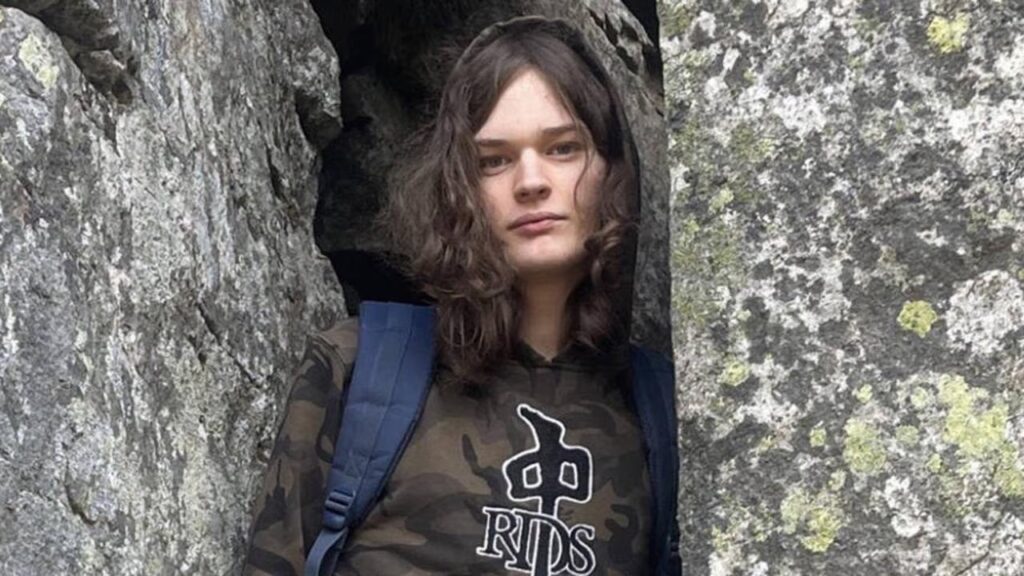

OpenAI przyznało, że konto Jesse Van Rootselaar – 18-latki odpowiedzialnej za masakrę w kanadyjskim Tumbler Ridge – zostało wewnętrznie oznaczone jako niebezpieczne już w czerwcu 2025 roku. Siedem miesięcy później, 10 lutego 2026, Van Rootselaar zabiła osiem osób, w tym pięcioro dzieci, a potem siebie.

Sprawa wstrząsnęła Kanadą i rozbudziła na nowo debatę o tym, czym są i czym powinny być systemy AI w kontekście bezpieczeństwa publicznego.

Co dokładnie się stało?

Van Rootselaar najpierw zastrzeliła matkę i 11-letniego przyrodniego brata w rodzinnym domu. Potem pojechała do Tumbler Ridge Secondary School – miejscowej szkoły średniej – i tam zabiła pięcioro uczniów oraz asystentkę nauczyciela. Następnie odebrała sobie życie. Według RCMP, policja kanadyjska odwiedzała dom rodziny wielokrotnie wcześniej w związku z problemami psychicznymi nastolatki. Van Rootselaar była zatrzymywana na podstawie Ustawy o Zdrowiu Psychicznym więcej niż raz.

Tymczasem w czerwcu 2025 roku automatyczne systemy OpenAI wykryły na jej koncie ChatGPT treści dotyczące scenariuszy przemocy z użyciem broni palnej. Konto trafiło do „wyspecjalizowanego pipeline’u” – jak opisuje to sam OpenAI – gdzie przeglądali je przeszkoleni pracownicy. I tu zaczyna się problem.

Według doniesień Wall Street Journal, część pracowników OpenAI chciała powiadomić organy ścigania. Ich obawy zostały odrzucone. Konto zablokowano, ale policja nie dowiedziała się nic – aż do chwili, gdy było już za późno.

„Nie spełniało progu”

OpenAI tłumaczy się korporacyjnym językiem, który w tym kontekście brzmi szczególnie zimno. Firma twierdzi, że aktywność Van Rootselaar „nie spełniła wyższego progu wymaganego” do zgłoszenia sprawy organom ścigania. Ten próg to – cytując oficjalne stanowisko – „bezpośrednie i wiarygodne ryzyko poważnej fizycznej krzywdy wobec innych.”

Kto i według jakiego klucza ocenia, czy ryzyko jest „bezpośrednie”? Tego OpenAI nie wyjaśnia.

Piotr Wolniewicz, Redaktor Naczelny AIPORT.pl:

Zanim rzucimy się z oskarżeniami pod adresem OpenAI, zatrzymajmy się na chwilę. Z jednej strony – tak, siedem osób innych niż sprawczyni zginęło, a algorytm miał sygnały. To jest fakt brutalny i nie można go zbagatelizować. Ale z drugiej: systemy AI codziennie wykrywają tysiące niepokojących konwersacji. Gdzie przebiega granica między wyrazem frustracji a realnym zamiarem? Kto podejmuje tę decyzję – człowiek, algorytm, prawnik korporacyjny? I co się stanie, gdy firmy AI zaczną masowo raportować użytkowników do policji na podstawie tego, co piszą w chatbocie? To otwiera drzwi do czegoś, co może być równie niebezpieczne – inwigilacji przez proxy. Nie mówię, że OpenAI postąpiło słusznie. Mówię, że to jest pytanie bez łatwej odpowiedzi i musimy je postawić zanim zaczniemy pisać prawo.

Równoległy ślad – Roblox i symulacja masakry

Sprawa ChatGPT to nie jedyny wątek cyfrowy. Van Rootselaar stworzyła na platformie Roblox symulację masakry w centrum handlowym – grę, w której postać biegała po galerii i strzelała do innych. Roblox usunął konto i wszelkie powiązane treści 11 lutego 2026, dzień po tragedii, deklarując pełną współpracę z organami ścigania.

To pokazuje szerszy wzorzec. Niepokojące zachowania online nie ograniczały się do jednej platformy. Mimo to żadna z firm nie zaalarmowała władz przed atakiem.

Co dalej z OpenAI?

Po tragedii firma „proaktywnie skontaktowała się” z RCMP i przekazuje informacje o aktywności Van Rootselaar na platformie. Rzecznik RCMP, Staff Sgt. Kris Clark, potwierdził kontakt i zapowiedział gruntowną analizę aktywności online sprawczyni. Zaznaczył też, że nagłówek Wall Street Journal mówiący o „alarmach” ze strony pracowników OpenAI był „nieco mylący” – firma flagowała konto wewnętrznie, nie informując władz.

OpenAI ogłosiło, że przegląda kryteria, według których decyduje o zgłoszeniu spraw do organów ścigania. Nie wiadomo, czy i kiedy zmienią się procedury.

Pytania, które pozostają

Ta sprawa stawia przed branżą AI kilka fundamentalnych kwestii:

- Kto decyduje o tym, kiedy firma technologiczna powinna poinformować policję o użytkowniku?

- Jaka odpowiedzialność prawna spoczywa na platformach AI w przypadku, gdy nie zgłoszą niepokojącej aktywności?

- Czy możliwe jest stworzenie skutecznych systemów wczesnego ostrzegania bez naruszania prywatności milionów użytkowników?

- Jak chronić dzieci w środowisku, gdzie kilka platform jednocześnie wysyłało sygnały alarmowe, a żadna nie połączyła kropek?

Ofiary tragedii w Tumbler Ridge to: Zoey Benoit, Ticaria Lampert, Abel Mwansa, Ezekiel Schofield, Kylie Smith, Shannda Aviugana-Durand (uczniowie szkoły), Jennifer Jacobs (matka sprawczyni) oraz Emmett Jacobs, 11-letni przyrodni brat Van Rootselaar. Rodzina Abela Mwansy organizuje repatriację jego ciała do Zambii.

Technologia miała sygnały. Zabrakło decyzji.